一、kubernetes概述

1.1、kubernetes 基本介绍

kubernetes,简称 K8s,是用 8 代替 8 个字符 ubernete 而成的缩写。是一个开源 的,用于管理云平台中多个主机上的容器化的应用,Kubernetes 的目标是让部署容器化的 应用简单并且高效(powerful),Kubernetes 提供了应用部署,规划,更新,维护的一种机制。

传统的应用部署方式是通过插件或脚本来安装应用。这样做的缺点是应用的运行、配置、管理、所有生存周期将与当前操作系统绑定,这样做并不利于应用的升级更新/回滚等操作,当然也可以通过创建虚拟机的方式来实现某些功能,但是虚拟机非常重,并不利于可移植性。

新的方式是通过部署容器方式实现,每个容器之间互相隔离,每个容器有自己的文件系统 ,容器之间进程不会相互影响,能区分计算资源。相对于虚拟机,容器能快速部署, 由于容器与底层设施、机器文件系统解耦的,所以它能在不同云、不同版本操作系统间进行迁移。

容器占用资源少、部署快,每个应用可以被打包成一个容器镜像,每个应用与容器间成一对一关系也使容器有更大优势,使用容器可以在 build 或 release 的阶段,为应用创建容器镜像,因为每个应用不需要与其余的应用堆栈组合,也不依赖于生产环境基础结构,这使得从研发到测试、生产能提供一致环境。类似地,容器比虚拟机轻量、更“透明”, 这更便于监控和管理。

Kubernetes 是 Google 开源的一个容器编排引擎,它支持自动化部署、大规模可伸缩、 应用容器化管理。在生产环境中部署一个应用程序时,通常要部署该应用的多个实例以便对应用请求进行负载均衡。

在 Kubernetes 中,可以创建多个容器,每个容器里面运行一个应用实例,然后通过内置的负载均衡策略,实现对这一组应用实例的管理、发现、访问,而这些细节都不需要运维人员去进行复杂的手工配置和处理。

1.2、kubernetes 功能和架构

1.2.1、概述

Kubernetes 是一个轻便的和可扩展的开源平台,用于管理容器化应用和服务。通过 Kubernetes 能够进行应用的自动化部署和扩缩容。在 Kubernetes 中,会将组成应用的容 器组合成一个逻辑单元以更易管理和发现。Kubernetes 积累了作为 Google 生产环境运行工作负载 15 年的经验,并吸收了来自于社区的最佳想法和实践。

1.2.2、K8s 功能

(1)自动装箱

基于容器对应用运行环境的资源配置要求自动部署应用容器。

(2)自我修复(自愈能力)

当容器失败时,会对容器进行重启。

当所部署的 Node 节点有问题时,会对容器进行重新部署和重新调度。

当容器未通过监控检查时,会关闭此容器直到容器正常运行时,才会对外提供服务。

(3)水平扩展

通过简单的命令、用户 UI 界面或基于 CPU 等资源使用情况,对应用容器进行规模扩大或规模剪裁。

(3)服务发现

用户不需使用额外的服务发现机制,就能够基于 Kubernetes 自身能力实现服务发现和负载均衡。

(4)滚动更新

可以根据应用的变化,对应用容器运行的应用,进行一次性或批量式更新。

(5)版本回退

可以根据应用部署情况,对应用容器运行的应用,进行历史版本即时回退。

(6)密钥和配置管理

在不需要重新构建镜像的情况下,可以部署和更新密钥和应用配置,类似热部署。

(7)存储编排

自动实现存储系统挂载及应用,特别对有状态应用实现数据持久化非常重要存储系统可以来自于本地目录、网络存储(NFS、Gluster、Ceph 等)、公共云存储服务。

(8)批处理

提供一次性任务,定时任务;满足批量数据处理和分析的场景。

1.2.3、应用部署架构分类

(1) 无中心节点架构

GlusterFS

(2) 有中心节点架构

HDFS

K8S

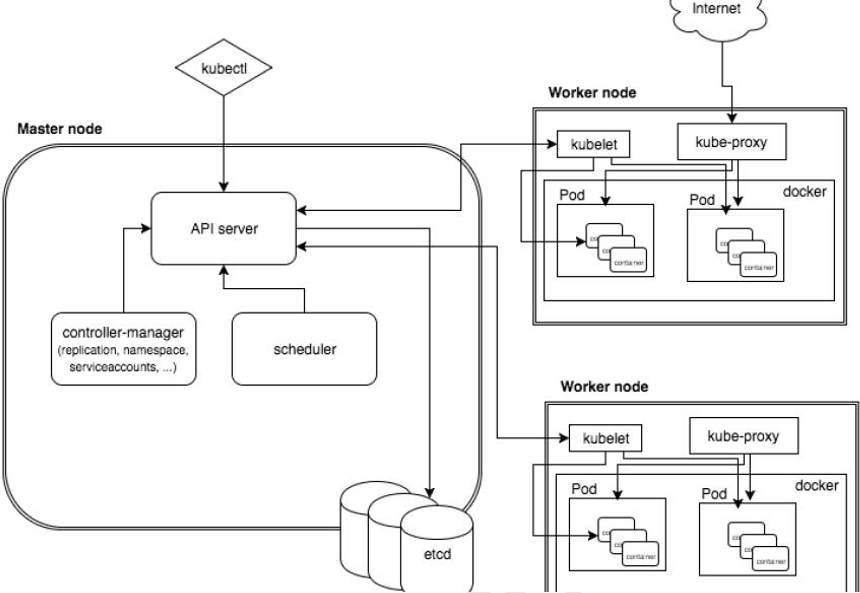

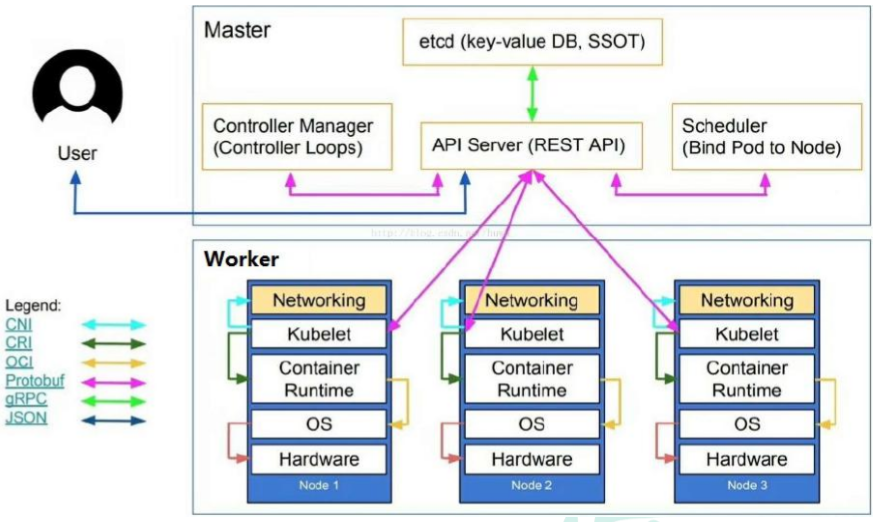

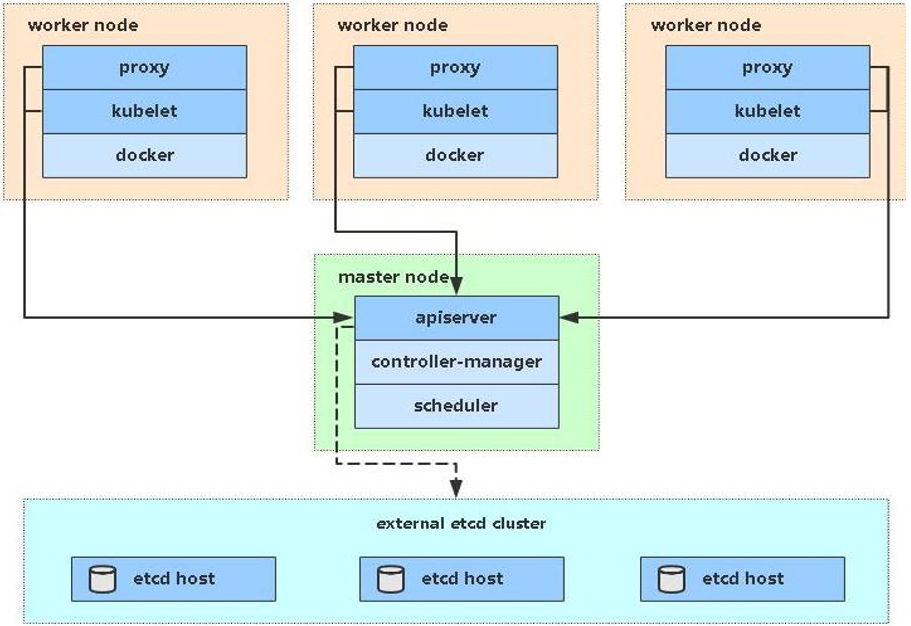

1.2.4、k8s 集群架构

1.2.5、k8s 集群架构节点角色功能

- Master Node

k8s 集群控制节点,对集群进行调度管理,接受集群外用户去集群操作请求;Master Node 由 API Server、Scheduler、ClusterState Store(ETCD 数据库)和 Controller MangerServer 所组成。 - Worker Node

集群工作节点,运行用户业务应用容器;

Worker Node 包含 kubelet、kube proxy 和 ContainerRuntime;

二、kubernetes 集群搭建(kubeadm 方式)

2.1、前置知识点

目前生产部署 Kubernetes 集群主要有两种方式:

- kubeadm

Kubeadm 是一个 K8s 部署工具,提供kubeadm init和kubeadm join,用于快速部署 Kubernetes 集群。

官方地址:https://kubernetes.io/docs/... - 二进制包

从 github 下载发行版的二进制包,手动部署每个组件,组成 Kubernetes 集群。

Kubeadm 降低部署门槛,但屏蔽了很多细节,遇到问题很难排查。如果想更容易可控,推荐使用二进制包部署 Kubernetes 集群,虽然手动部署麻烦点,期间可以学习很多工作原理,也利于后期维护。

2.2、kubeadm 部署方式介绍

kubeadm 是官方社区推出的一个用于快速部署 kubernetes 集群的工具,这个工具能通 过两条指令完成一个 kubernetes 集群的部署:

- 创建一个 Master 节点

kubeadm init - 将 Node 节点加入到当前集群中

$ kubeadm join <Master 节点的 IP 和端口 >

2.3、安装要求

在开始之前,部署 Kubernetes 集群机器需要满足以下几个条件:

一台或多台机器,操作系统 CentOS7.x-86_x64

硬件配置:2GB 或更多 RAM,2 个 CPU 或更多 CPU,硬盘 30GB 或更多

集群中所有机器之间网络互通

可以访问外网,需要拉取镜像

禁止 swap 分区

2.4、最终目标

(1) 在所有节点上安装 Docker 和 kubeadm

(2)部署 Kubernetes Master

(3)部署容器网络插件

(4)部署 Kubernetes Node,将节点加入 Kubernetes 集群中

(5)部署 Dashboard Web 页面,可视化查看 Kubernetes 资源

2.5、准备环境

角色 IP

k8smaster 192.168.10.146

k8snode1 192.168.10.145

k8snode2 192.168.10.144

2.6、系统初始化

1、关闭防火墙:

systemctl stop firewalld

systemctl disable firewalld

2、关闭 selinux:

sed -i 's/enforcing/disabled/' /etc/selinux/config # 永久

setenforce 0 # 临时

3、关闭 swap:

swapoff -a # 临时

sed -ri 's/.*swap.*/#&/' /etc/fstab # 永久

4、主机名:

hostnamectl set-hostname <hostname>

5、在 master 添加 hosts:

cat >> /etc/hosts << EOF

192.168.10.146 k8smaster

192.168.10.145 k8snode1

192.168.10.144 k8snode2

EOF

6、将桥接的 IPv4 流量传递到 iptables 的链:

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system # 生效

7、时间同步:

yum install ntpdate -y

ntpdate time.windows.com

2.7、所有节点安装 Docker/kubeadm/kubelet

Kubernetes 默认 CRI(容器运行时)为 Docker,因此先安装 Docker。

(1)安装 Docker

yum install wget

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

yum -y install docker-ce-18.06.1.ce-3.el7

systemctl enable docker && systemctl start docker

docker --version

(2)添加阿里云 YUM 软件源

设置仓库地址

cat > /etc/docker/daemon.json << EOF

{

"registry-mirrors": ["https://registry.cn-hangzhou.aliyuncs.com"]

}

EOF

添加 yum 源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

(3)安装 kubeadm,kubelet 和 kubectl

kubelet:运行在 cluster,负责启动 pod 管理容器。kubeadm:k8s 快速构建工具,用于初始化 cluster。kubectl:k8s 命令工具,部署和管理应用,维护组件。

由于版本更新频繁,这里指定版本号部署:

yum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0

systemctl enable kubelet

1.18.0 版本和 linux 3.1 内核存在问题,可以使用其他版本:

# 1、配置关闭 Docker 的 cgroups,修改 /etc/docker/daemon.json,加入以下内容

"exec-opts": ["native.cgroupdriver=systemd"]

# 2、重启 docker

systemctl daemon-reload

systemctl restart docker

# 3、安装kubelet、kubeadm、kubectl

# yum install -y kubelet-1.23.6 kubeadm-1.23.6 kubectl-1.23.6

yum install -y kubelet kubeadm kubectl

# 4、配置kubelet的cgroup

# 编辑/etc/sysconfig/kubelet, 添加下面的配置

KUBELET_CGROUP_ARGS="--cgroup-driver=systemd"

# 5、设置kubelet开机自启

systemctl enable kubelet

查看是否安装成功:

kubelet --version

kubectl version

kubeadm version

启动 kubelet

systemctl daemon-reload

systemctl start kubelet

systemctl enable kubelet

拉取 init-config 配置并修改配置:

init-config 主要是由 api server、etcd、scheduler、controller-manager、coredns 等镜像构成。

kubeadm config print init-defaults > init-config.yaml

修改刚才拉取的 init-config.yaml 文件:

[root@localhost /]# cat init-config.yaml

apiVersion: kubeadm.k8s.io/v1beta3

bootstrapTokens:

- groups:

- system:bootstrappers:kubeadm:default-node-token

token: abcdef.0123456789abcdef

ttl: 24h0m0s

usages:

- signing

- authentication

kind: InitConfiguration

localAPIEndpoint:

advertiseAddress: 192.168.34.7 #master节点IP地址

bindPort: 6443

nodeRegistration:

criSocket: /var/run/dockershim.sock

imagePullPolicy: IfNotPresent

name: master #master节点node的名称

taints: null

---

apiServer:

timeoutForControlPlane: 4m0s

apiVersion: kubeadm.k8s.io/v1beta3

certificatesDir: /etc/kubernetes/pki

clusterName: kubernetes

controllerManager: {}

dns: {}

etcd:

local:

dataDir: /var/lib/etcd

imageRepository: registry.aliyuncs.com/google_containers #修改为阿里云地址

kind: ClusterConfiguration

kubernetesVersion: 1.23.0

networking:

dnsDomain: cluster.local

serviceSubnet: 10.96.0.0/12

scheduler: {}

2.8、部署 KubernetesMaster

(1)在 192.168.10.146(Master)执行

kubeadm init \

--apiserver-advertise-address=192.168.10.146 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.18.0 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16

由于默认拉取镜像地址 k8s.gcr.io 国内无法访问,这里指定阿里云镜像仓库地址。

(2)使用 kubectl 工具:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

# 查看所有节点

kubectl get nodes

2.9、安装 Pod 网络插件(CNI)

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

确保能够访问到 quay.io 这个 registery。如果 Pod 镜像下载失败,可以改这个镜像地址。

使用如下文件进行安装:

kubectl apply -f kube-flannel.yaml

>>>>>>

kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

kube-flannel-ds-amd64-2pc95 1/1 Running 0 72s

kube-flannel.yaml

kube-flannel.yaml

2.10、加入 Kubernetes Node

(1)在 192.168.31.145/144(Node)执行

向集群添加新节点,执行在 kubeadm init 输出的 kubeadm join 命令:

kubeadm join 192.168.10.146:6443 --token ksy8do.s11iif12bjbi9lnh \

--discovery-token-ca-cert-hash sha256:73d8160a22ab856806d7774bd4f8cd55f43ae65ba426137af6118ddd61d08cf4

在 node 节点上正确配置 kubectl 的配置文件

1、首先在 master 节点上获取 kubeconfig 文件内容:

# 在 master 节点上执行

cat /etc/kubernetes/admin.conf

2、在 node 节点上创建必要的目录和配置文件:

# 在 node 节点上执行

mkdir -p $HOME/.kube

3、将 master 节点的配置复制到 node 节点:

方法一:直接从 master 复制文件(推荐)

# 在 node 节点上执行(需要替换 master_ip 为实际的 master 节点 IP)

scp root@<master_ip>:/etc/kubernetes/admin.conf $HOME/.kube/config

方法二:手动创建配置文件

# 在 node 节点上执行

vim $HOME/.kube/config

# 将从 master 节点复制的内容粘贴到这个文件中

4、设置正确的权限:

# 在 node 节点上执行

chmod 600 $HOME/.kube/config

5、验证配置:

# 在 node 节点上执行

kubectl get nodes

2.11、测试 kubernetes 集群

在 Kubernetes 集群中创建一个 pod,验证是否正常运行:

$ kubectl create deployment nginx --image=nginx

$ kubectl expose deployment nginx --port=80 --type=NodePort

$ kubectl get pod,svc

访问地址:http://NodeIP:Port

三、集群关闭/启动

3.1、关闭集群

按照以下顺序关闭集群:

1、首先驱逐工作节点上的 Pod:

kubectl drain <node-name> --ignore-daemonsets

2、在每个节点上停止 kubelet 服务:

sudo systemctl stop kubelet

3、在每个节点上停止 Docker/containerd:

sudo systemctl stop docker # 如果使用 Docker

# 或

sudo systemctl stop containerd # 如果使用 containerd

3.2、启动集群

按照以下顺序重新启动集群:

1、在每个节点上启动容器运行时:

sudo systemctl start docker # 如果使用 Docker

# 或

sudo systemctl start containerd # 如果使用 containerd

2、在每个节点上启动 kubelet:

sudo systemctl start kubelet

3、取消节点的驱逐状态:

kubectl uncordon <node-name>

四、问题&卸载

之前有使用 kubeadm 安装过,需要提前把之前的 kube 文件删除掉。

rm -rf $HOME/.kube

查看 token 信息以及生成永久 token。

查看存在的 token:

kubeadm token list

生成永久 token:

kubeadm token create --ttl 0

生成 Master 节点的 ca 证书 sha256 编码 hash 值:

openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed 's/^.* //'

在 master 节点查看 加入的 node 节点或删除节点:

kubectl get nodes

kubectl delete nodes 节点名称

master 节点删除 node 节点后,node 节点再次加入需要在 node 节点执行 kubeadm reset。

查看 kubelet 日志:

journalctl -xefu kubelet

卸载 k8s:

yum -y remove kubelet kubeadm kubectl

sudo kubeadm reset -f

sudo rm -rvf $HOME/.kube

sudo rm -rvf ~/.kube/

sudo rm -rvf /etc/kubernetes/

sudo rm -rvf /etc/systemd/system/kubelet.service.d

sudo rm -rvf /etc/systemd/system/kubelet.service

sudo rm -rvf /usr/bin/kube*

sudo rm -rvf /etc/cni

sudo rm -rvf /opt/cni

sudo rm -rvf /var/lib/etcd

sudo rm -rvf /var/etcd

参考:

kubeadm安装

评论